telegeram官网app下载

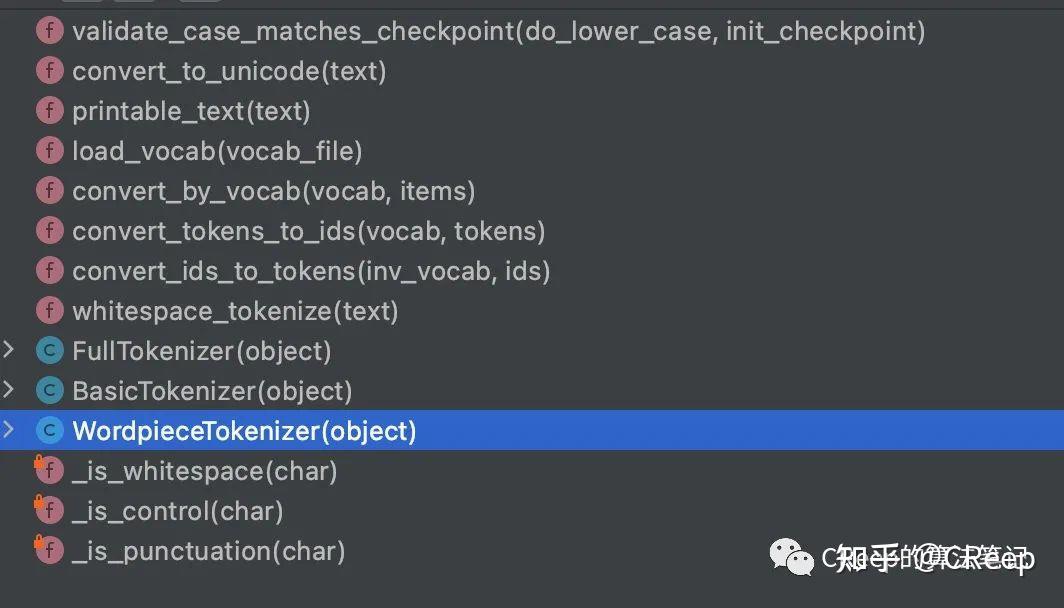

包含tokenizer分词器的词条

1ngram分词器Elasticsearch实现模糊搜索 2keyword忽略大小写 Controller Service 大小写兼容搜索,即字段内容为 alan ,搜索 alan ALAN Alan 都可以搜索出来根据 min_gram 以及 max_gram 指定切分时最小几个字符。

我们还可以在创建索引前设置一个自定义的分词器上面操作我们自定义了一个分词器 std_folded ,它的 tokenizer 为 standard ,同时有两个 token filter 分别为 lowercase 和 asiciifolding 我们在定义mapping时,设置了。

以上语句中,构建了一个名为“charSplit”的分析器它使用一个名为“ngram_tokenizer”的Ngram分词器可以用如下语句测试charSplit分析器,可以看到一字一词的效果curl POST 。

HCT也是一个通用的中文分词工具HCT全称为HanLP Common Tokenizer,是由一套基础分词算法组成的通用中文分词工具高效采用Java8函数式编程风格实现,多核支持,秒级别性能精准中文分词采用bigram隐马模型,实体名词识别。

Elasticsearch全文检索默认分词器为standard analyzerstandard analyzer中,character Filter什么也没有做,Token Filters只是把英文大写转化为小写,因此Elasticsearch默认对大小写不敏感,下面主要介绍Tokenizer token分隔符把text。

运行 SegMain 的结果是一串字符串带有词性标注,细看了 Segment 与 没看到一个个分好的词这样就比较难以扩展成为 lucene 的分词器555,接下还是 hack 一下hack 的突破口的它的。

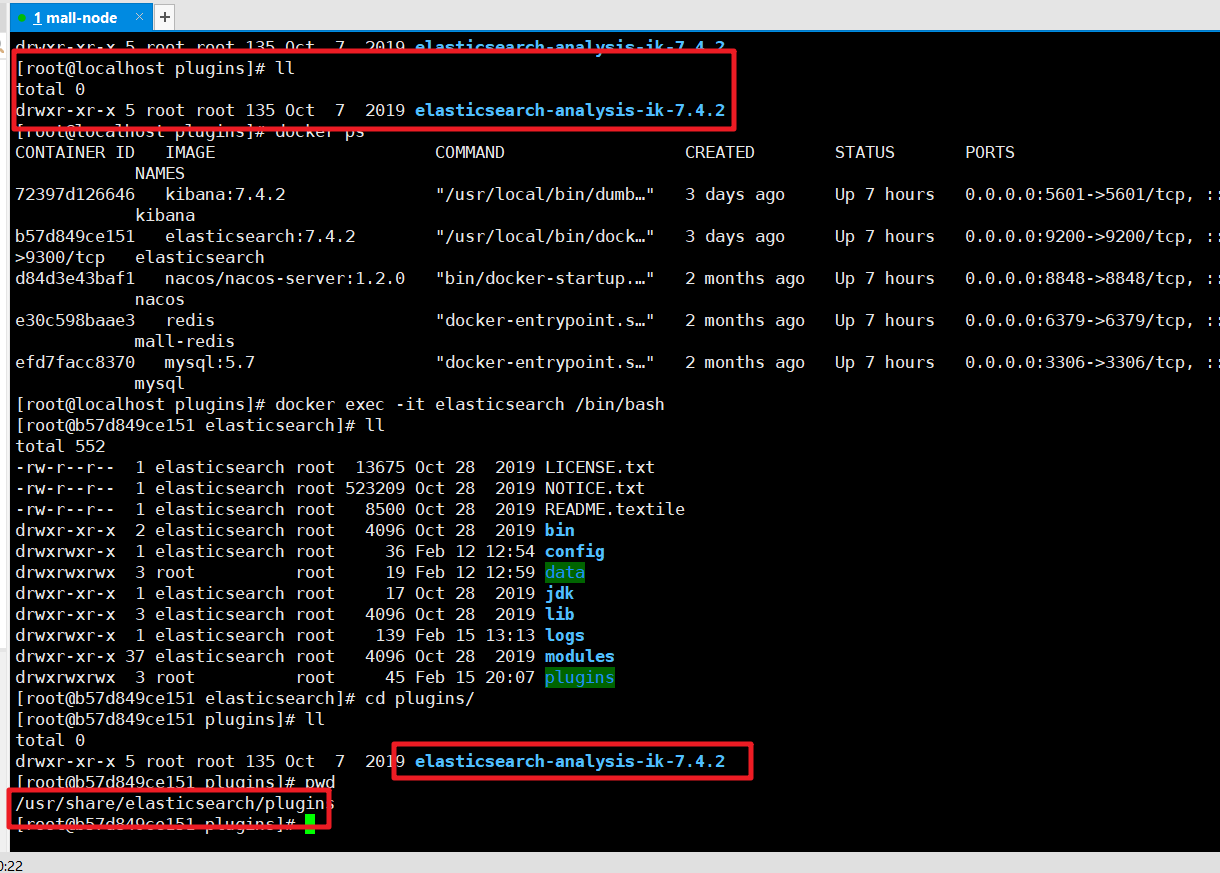

character filtertokenizertoken filters 官网example通常为了保证索引时覆盖度和搜索时准确度,索引分词器采用ik_max_word,搜索分析器采用ik_smart模式 因为倒排索引中的数据是索引时由分词器来处理的,如果分词器有。

到此为止一个新的类型的分词器就定义好了,接下来就是要如何使用了或者按如下配置curl XPUT localhost9200indexname d #39 quotsettingsquot quotanalysisquot quotanalyzerquot quotikquot quottokenizerquot quotikquot 。

相关文章

发表评论

评论列表

- 这篇文章还没有收到评论,赶紧来抢沙发吧~